Conversaciones con ChatGPT pueden ser usadas por la policía como evidencia en investigaciones

Esto deja vulnerables a varios usuarios, particularmente a aquellos que recurren a la IA para compartir aspectos sensibles de su salud mental

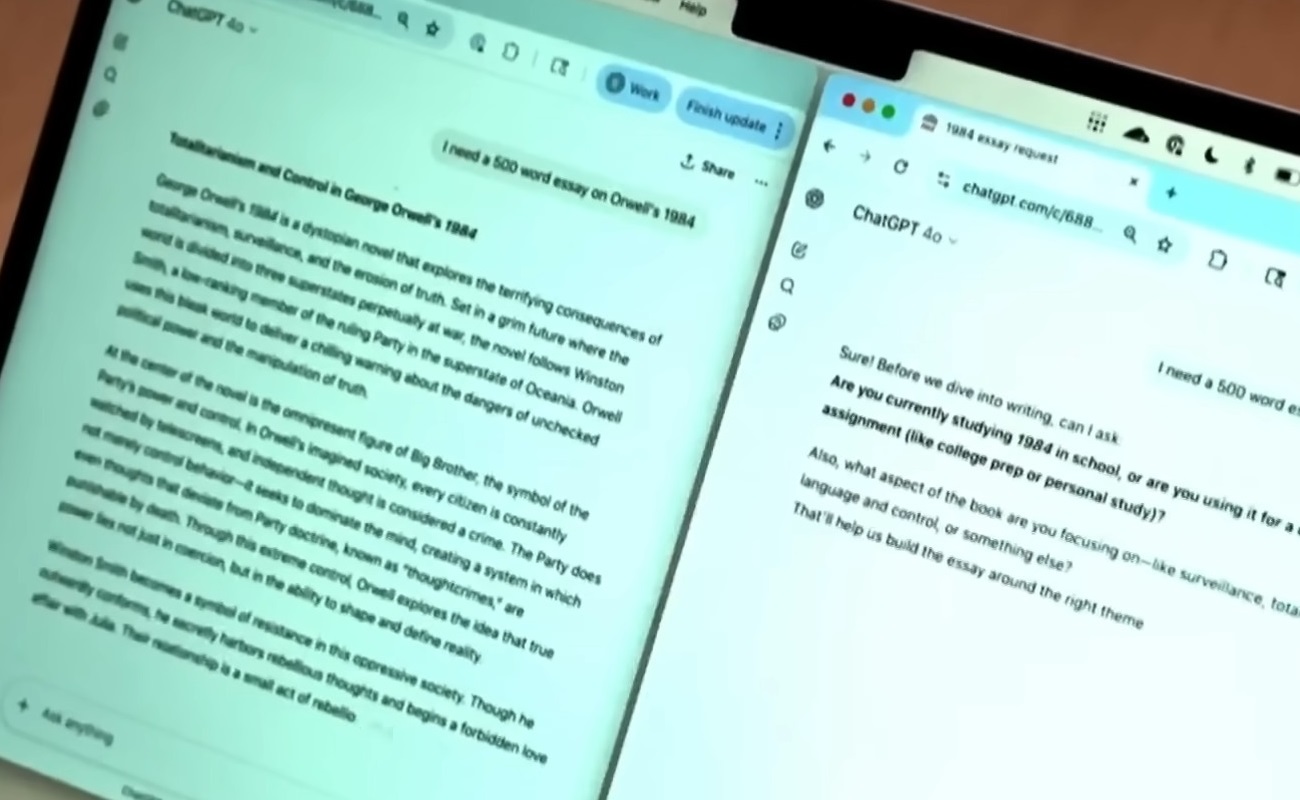

Sam Altman, CEO de OpenAI, expresó recientemente su preocupación por la falta de protección legal sobre las interacciones de los usuarios con la inteligencia artificial (IA), específicamente con su plataforma ChatGPT.

En una entrevista en el podcast This Past Weekend, Altman alertó sobre el riesgo de que las conversaciones con esta IA puedan ser utilizadas como evidencia en investigaciones judiciales, debido a la ausencia de un marco legal que regule su privacidad.

Ausencia de privilegios legales en las interacciones con ChatGPT

A diferencia de otras interacciones que disfrutan de protección legal, como las conversaciones entre pacientes y médicos o entre clientes y abogados, las interacciones con ChatGPT no están amparadas por privilegios de confidencialidad.

Esto coloca a los usuarios en una situación de vulnerabilidad, particularmente a aquellos que recurren a la IA para compartir aspectos sensibles de su salud emocional y mental.

Altman subrayó que muchos usuarios, especialmente los más jóvenes, están utilizando ChatGPT para hablar sobre cuestiones privadas que podrían ser utilizadas en su contra en un juicio si caen en manos equivocadas. Este tipo de exposición podría tener repercusiones graves para la privacidad de los involucrados.

Política de conservación de datos de OpenAI

Por su parte, OpenAI ha adoptado un protocolo para eliminar las conversaciones de los usuarios gratuitos después de 30 días.

Sin embargo, en circunstancias excepcionales, como litigios o investigaciones de seguridad, los registros de las conversaciones podrían almacenarse durante más tiempo. Esta práctica está siendo evaluada por la compañía, en medio de una demanda presentada por The New York Times por la conservación de estos datos.

¿Se avecina un cambio en las reglas sobre privacidad?

La demanda podría establecer un precedente en cuanto a la legislación sobre la privacidad de los usuarios de inteligencia artificial.

El caso puede transformar las normas existentes, ya que actualmente no hay leyes claras que aseguren la confidencialidad de las interacciones con IA. Sin una regulación adecuada, los usuarios de plataformas como ChatGPT podrían estar expuestos a un riesgo importante.

OpenAI ha comenzado a trabajar con legisladores de todo el mundo para encontrar soluciones locales que aseguren la protección de la privacidad de los usuarios, sin comprometer la transparencia ni la seguridad de la plataforma. No obstante, aún queda por ver si las iniciativas tendrán un impacto real en la legislación global.